Das KI-Gesetz der Europäischen Union fordert in weiten Bereichen Transparenz für KI. Die Ursache ist nicht nur, dass bestimmte KI-Systeme unsere Sicherheit und Grundrechte gefährden könnten, sondern dass es den Durchsetzungsbehörden sonst schwerfallen würde, die Einhaltung bestehender Vorschriften zu überprüfen. Die daraus resultierende Rechtsunsicherheit könnte bei Bürgern und Unternehmen zu fehlendem Vertrauen in KI führen. Eine zögerliche Inanspruchnahme von KI-Technologien und regulatorische Eingriffe durch Behörden wären die Folge.

Als Gegenmaßnahmen hat die EU-Kommission Folgendes vorgeschlagen:

- Gewährleistung der Sicherheit von KI-Systemen,

- Rechtssicherheit für KI-Anbieter und

- gezielte Marktentwicklung für vertrauenswürdige KI, um der europäischen Industrie einen globalen Wettbewerbsvorteil zu verschaffen.

Für Hochrisiko-KI-Anwendungen (schätzungsweise zwischen 5 % und 15 % aller KI-Anwendungen) wird es verbindliche Anforderungen geben. Ein Großteil der EU-Bürger ist jedoch der Meinung, dass diese Vorgaben nicht auf diesen kleinen Teil der KI-Systeme beschränkt bleiben sollten.

Die oben genannten Ziele werden anvisiert durch

- neue Anforderungen an die Dokumentation,

- die Rückverfolgbarkeit und

- Transparenz der KI-Systeme.

Nach Schätzungen der Europäischen Kommission werden der Aufwand zur Erfüllung der rechtlichen Anforderungen an Hochrisiko-KI und die Überprüfungskosten zusammen bis zu 10 % der Investitionen betragen. Gleiches würde sicher für Unternehmen gelten, die sich, z. B. aus Gründen der Produktsicherheit und -haftung, freiwillig entsprechenden Verhaltenskodizes anschließen.

KI kompakt erklärt

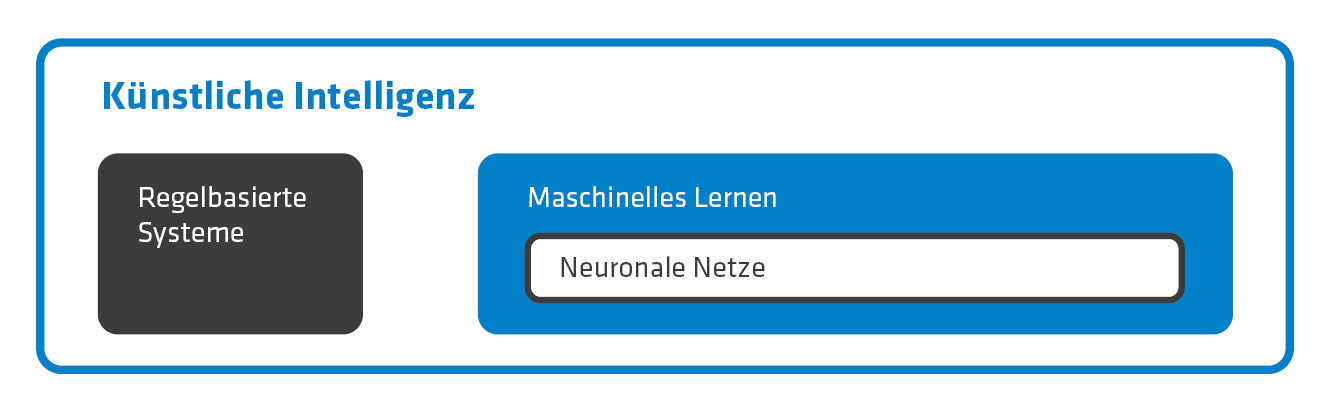

Der Begriff Künstliche Intelligenz – gleichbedeutend sind KI-System oder KI – ist in aller Munde, aber was genau steckt eigentlich dahinter? Es handelt sich dabei um einen Oberbegriff für IT-Systeme, die versuchen, den menschlichen Einsatz von Intelligenz nachzuahmen, d. h. selbst zu „denken“. Zu ihrer Umsetzung stehen zwei unterschiedliche Ansätze zur Verfügung: die Regelbasierten Systeme und das Maschinelle Lernen (siehe Abb. 1).

Regelbasierte Systeme verwenden ausschließlich vorgegebene Regeln, weshalb ihre Funktionsweise prinzipiell vorhergesagt werden kann. Beim Maschinellen Lernen hingegen kommen dynamische Algorithmen zum Einsatz, die durch das Approximieren von Korrelationen selbstständig dazulernen. Das Verhalten solcher Systeme ist daher grundsätzlich nicht vorhersehbar. Es gibt viele Wege zu ihrer Implementierung. Unter ihnen haben die Neuronalen Netze wegen ihrer Einfachheit weite Verbreitung gefunden.

Abb. 1: Die beiden grundlegenden Methoden der Künstlichen Intelligenz sind die Regelbasierten Systeme und das Maschinelle Lernen. Eine Variante des Maschinellen Lernens sind die Neuronalen Netze.

Abb. 1: Die beiden grundlegenden Methoden der Künstlichen Intelligenz sind die Regelbasierten Systeme und das Maschinelle Lernen. Eine Variante des Maschinellen Lernens sind die Neuronalen Netze.

BaFin nimmt Modellierer in die Pflicht

Nicht nur auf europäischer Ebene sieht sich der Gesetzgeber dazu veranlasst, KI zu regulieren. Auch in Deutschland, beispielsweise im Finanzsektor, wird der Einfluss Künstlicher Intelligenz entsprechend spürbar. Zwar kommt die Bundesanstalt für Finanzdienstleistungsaufsicht (BaFin) bei der Beurteilung ihrer Überwachungstätigkeit in Bezug auf KI-Systeme zu dem Ergebnis, dass keine grundsätzliche Änderung ihrer Vorgehensweise erforderlich ist. Die umfangreichen Regeln zur Überprüfung und Genehmigung sind technikneutral formuliert und die Anforderungen setzen sich aus Prinzipien zusammen, die jeweils fallspezifisch ausgelegt werden. Dadurch steht die Aufsichtspraxis auf einer soliden Grundlage.

Es fällt jedoch ins Gewicht, dass sich Neuronale Netze grundsätzlich wie eine Blackbox verhalten. Hinzu kommt die wachsende Komplexität sowie die Dimensionalität der Modelle. Um mit dieser Entwicklung Schritt zu halten, muss das Anliegen aufgegeben werden, diese Modelle nachvollziehen zu wollen. Stattdessen rückt die Erklärbarkeit ihres Verhaltens in den Fokus. Daher werden die Modellierer durch die BaFin in die Pflicht genommen, jedwede Verschlechterung der Erklärbarkeit plausibel zu begründen.

Die Fähigkeit zur Selbstoptimierung Künstlicher Intelligenz stellt eine weitere aufsichtsrechtliche Herausforderung dar. In der Folge müssen Änderungen an Modellen gemeldet werden, und sie dürfen ggf. erst nach Genehmigung wieder in Betrieb genommen werden. Die Selbstveränderung der KI-Systeme ist deshalb genau zu untersuchen und zu dokumentieren.

Ein Protokoll für die Entscheidungsfindung

Aus all dem kristallisiert sich als wichtiges Ziel heraus, Transparenz für KI herzustellen. Nur eine scheinbare Lösung wäre es, für die KI-Neuronen den zeitlichen Verlauf der Aktivitäten und ihrer gegenseitigen Verschaltung aufzunehmen. Dadurch wird zwar eine Messbarkeit erzeugt, die aber von der Erklärbarkeit noch weit entfernt ist.

Ein anderer unbefriedigender Ansatz sind Blackbox-Analysen, wie z. B. Local Interpretable Model-Agnostic Explanations (LIME). Sie können nur lokal weiterhelfen, nicht aber die volle Komplexität von KI ergründen. Was wirklich benötigt wird, ist eine klare Dokumentation der vom KI-System getroffenen Entscheidungen. Ähnlich der kausalen Kette bei einer richterlichen Entscheidung muss die Vorgehensweise der KI in jeder Stufe nachvollziehbar werden.

Eine passende Lösung haben wir bei Think! 2021 vorgelegt: Mit dem Konzept der Rule-Based Neural Networks (RBNN) gingen wir als Sieger aus diesem Innovationswettbewerb der adesso SE hervor. RBNN entstehen, indem wir zwei an sich gegensätzliche Methoden für Künstliche Intelligenz zu einer Symbiose vereinen: Regelbasierte Systeme und Neuronale Netze. Im Ergebnis liefert die KI zu jeder von ihr gegebenen Antwort automatisch ein Protokoll über ihren Entscheidungsfindungsprozess mit. Darüber hinaus entsteht ein selbstlernendes KI-System, weil das Protokoll unmittelbar an das Neuronale Netz zurückgekoppelt werden kann.

Der Traum von der unfehlbaren KI

Die Künstliche Intelligenz wird durch den Einsatz von RBNN jedoch nicht automatisch frei von Unsicherheiten. Auch diese KI-Lösung basiert auf von Menschen vorgegebenen Strukturen und bearbeitet von Menschen vorgegebene Fragestellungen anhand von Eingabedaten, die durch Menschen arrangiert wurden. Wenn die Eingangsdaten in sich unstimmig sind oder die aufgestellten Regeln eine Fehlinterpretation erlauben, kann ein System mehrere widersprüchliche Aussagen herleiten und dadurch seine Eindeutigkeit verlieren.

Aber auch ein unberücksichtigter Zusammenhang, z. B. die verloren gegangene Gültigkeit einer Folgerung, kann bereits zum Verlust der Kohärenz führen. Daher muss auch für RBNN davon ausgegangen werden, dass sie eine Neigung zu bestimmten „Denkmustern“ entwickeln und vertiefen können.

Angenommen, für eine KI gibt es mehrere mögliche Antworten auf eine Frage, und zu jeder Antwort kann sie eine schlüssige Argumentationskette vorlegen: Dann könnte sich auch die erklärbare KI eine Antwort „aussuchen“. Im menschlichen Miteinander ist das nicht anders, zum Beispiel auf dem Gebiet der Wissenschaft: Wenn mehrere Forscher eine auslegungsbedürftige Fragestellung diskutieren, bekommt man oft unterschiedliche Aussagen – obwohl alle Begründungen auf derselben Faktenlage beruhen und in sich schlüssig sind. Aus Erklärbarkeit kann zwar so etwas wie Objektivität entstehen, aber die Wahrheit finden wir so nicht.

Auf in die Zukunft mit Rule-Based Neural Networks!

Künstliche Intelligenz ist mit Sicherheit eine der – wenn nicht die IT-Technologie mit dem derzeit größten Anwendungspotenzial. Sie erkennt Betrug, unterstützt Menschen bei ihrer Arbeit und sortiert E-Mails. Zu ihren Einsatzgebieten gehört die Kundenberatung, Instandhaltung und Entscheidungsfindung. Zahlreiche ihrer zukünftigen Einsatzmöglichkeiten sind heute wahrscheinlich noch gar nicht bekannt.

Doch so vorteilhaft KI-Systeme sind, so viel Unsicherheit rufen sie auch bei Herstellern, Betreibern und in der Bevölkerung hervor. Dienstleister, Produzenten, Kunden – viele stehen der neuen Technologie mit Skepsis gegenüber. Nicht nur auf europäischer Ebene hat dies Konsequenzen, indem das KI-Gesetz u. a. Transparenz für KI-Systeme einfordert. Auch deutsche Behörden stellen, wie am Beispiel der BaFin gezeigt, zusätzliche Anforderungen an die Kompetenz und Verantwortlichkeit beim Herstellen und Anwenden von KI.

Wer seine KI frühzeitig fit für die Zukunft macht, ist vor Überraschungen sicher, die beim Einsatz undurchsichtiger KI-Systeme drohen. Mit transparenten KI hat man Behörden und Kunden auf seiner Seite. Da RBNN die gewünschte Transparenz herstellen können, lohnt es sich, diese kennenzulernen, – besser früher als später.

Wenn Sie mehr über den Einsatz von KI in der Versicherungsbranche erfahren möchten, empfehlen wir Ihnen unser kostenloses Whitepaper.